Google ist bekanntermaßen die meistgenutzte Suchmaschine der Welt – ca. 4 von 5 Suchanfragen auf der Erde gehen durch den Suchalgorithmus von Google (in Deutschland sogar 9 von 10), über eine Billiarde pro Jahr. Was in Google eingegeben wird, wird registriert und erfasst.Diese Masse an Suchanfragen führt Google seit einigen Jahren mit den Funktionen Google Instant und Google Autocomplete (vorher als Google Suggest bekannt) einem produktiven Zweck zu: Wann immer man eine Anfrage startet, wird der Eintrag in Echtzeit vom Alghoritmus vervollständigt auf der Basis der Popularität bestimmter Suchanfragen (d.h. das Suchvolumen für bestimmte Begriffe), dem Standort des Nutzers, der Aktualität der Suchanfrage und der Google-Historie des individuellen Nutzers.

Das lässt letztlich auch Aussagen über die Relevanz bestimmter Suchbegriffe zu. Was denken die Google-Nutzer (also fast alle Menschen mit Internetanschluss)? Was wollen sie erfahren? Was geben sie in die Suchmaske ein? Wenn man die Menge der Suchanfragen berücksichtigt, ist Google zumindest in dieser Hinsicht grundsätzlich ein guter Indikator für Fragen von allgemeinem Interesse, ob es sich nun um Trends oder dauerhaft Bedeutendes handelt.

Negativ konnotierte Suchanfragen

Hierzulande hat Google Suggest eine gewisse Berüchtigtkeit wegen problematischen Suchanfragen erlangt: Vor einigen Jahren ging Bettina Wulff gegen Google vor, um den Konzern zur Entfernung von Autocomplete-Vorschlägen zu bewegen, die die damalige Präsidentengattin in Verbindung mit dem ältesten Gewerbe der Welt brachten. Ähnlich gelagerte Fälle gab es auch in Frankreich, wo der Name einer Versicherung mit betrügerischen Praktiken verknüpft wurde, oder in Japan, wo der Name einer anonymen Einzelperson mit illegalen Aktivitäten einherging. Sogar eine Unterorganisation der UN richtete eine Beschwerde an Google, weil die Suchmuster der Nutzer weltweit dafür sorgten, dass frauenfeindliche Suchanfragen die Vorschläge für Suchanfragen Frauen betreffend dominierten.

Diese negativen Vorschläge sind aus mehreren Gründen nicht zu unterschätzen: Negative Optionen wecken eher das Interesse von Nutzern als neutrale oder positive, sie können das Bild des jeweiligen Subjekts der Suche schon im Vorfeld beeinflussen, ehe überhaupt auch nur eine Suchergebnisseite aufgerufen wurde, und schließlich können sie ein Bewusstsein für den Gegenstand des Vorschlags entwickeln, das vorher gar nicht vorhanden war (man danke an den erwähnten Fall Bettina Wulff). Im ungünstigsten Fall produzieren negative Suchanfragen entsprechende Autocomplete-Vorschläge, die dann wieder zu entsprechenden Suchanfragen führen und so den Teufelskreis fortführen – es sind schon Fälle bekannt worde, wo nach dem Entfernen eines negativen Vorschlags auch das Suchvolumen für diesen verschwand.

Grundsätzlich versucht Google, das Netz für Suggestionen allerdings etwas engmaschiger zu gestalten, damit zumindest die offensivsten und problematischsten Suchbegriffe nicht zu den Optionen werden. Neben Vorschlägen gewalttätiger, hasserfüllter und nicht jugendfreier Natur werden auch solche zu Online-Piraterie entfernt sowie solche, zu denen Google rechtlich verpflichtet wurde.

Google Suggest produktiv nutzen

Nun die Frage: Wie kann man sich diese Funktion zunutze machen? Am attraktivsten wäre es natürlich, wenn der eigene Name schon nach wenigen Buchstaben als primärer Vorschlag angezeigt und auch nur mit den positivsten Adjektiven als Suggestionen ausgeliefert würde, aber das wäre wenn überhaupt nur mit umfassendster Manipulation möglich – und die ist, hier sei es nur der Vollständigkeit halber erwähnt, dunkelste Black Hat-SEO.

Bleibt also die Alternative: Wenn man die Google Suggest-Vorschläge nicht dem eigenen Content anpassen kann, passt man den eigenen Content den Vorschlägen an. Das bezieht sich jetzt nicht unbedingt auf die eigene Seite – wenn es sich bei den vorgeschlagenen Begriffen um Eintagsfliegen handelt, wäre es nicht sehr zielführend, diese zu übernehmen; wenn es sich dagegen um solche von dauerhaftem Interesse und mit großem Suchvolumen handelt, ist die Wahrscheinlichkeit hoch, dass man diese bereits integriert hat (wobei es allerdings eine Überlegung wert wäre, Autocomplete als weiteres Standbein für die Früherkennung von Trends zu benutzen).

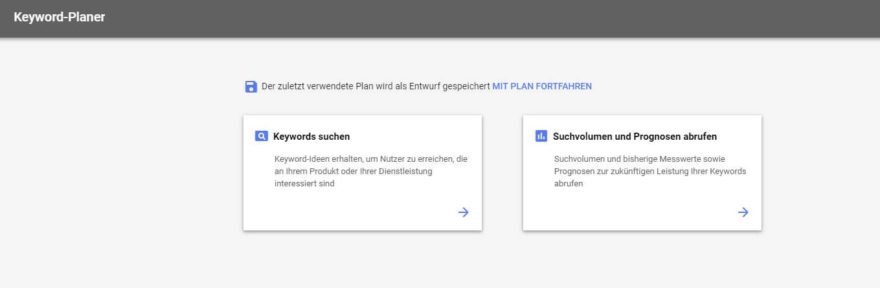

Mit Google Ads hat man allerdings die Möglichkeit, schnell und unkompliziert auf solche Suchanfragen-Spikes zu reagieren und von dem temporären Suchvolumen zu profitieren – und gleichzeitig weitere Kosten zu vermeiden, wenn der Trend wieder zurückgeht und mit ihm die Menge der Anfragen. Eine weitere Anwendungsmöglichkeit: Was Google geblacklistet hat, macht sich schlecht als Keyword im Content (wenn das eigene Geschäftsmodell nicht gerade auf diesen basiert), aber dafür umso besser als ausschließendes Keyword in den Adwords-Kampagnen.

Aber unabhängig davon, welchen Mehrwert man genau aus Google Autocomplete zieht – es ist auf jeden Fall zu mehr Nutze als nur zur persönlichen Unterhaltung.

UPDATE 13.08.2015

Google hat am 10. August den unautorisierten Zugriff auf die Autocomplete-API abgeschaltet. Für den User hat das keine Auswirkung. Aber viele Tools, welche die Schnittstelle bisher für Ihre Zwecke genutzt haben, verlieren nun ihre Datenquelle. Scheinbar waren Google diese Tools ein Dorn im Auge. Anbieter und SEOs müssen sich mal wieder nach Alternativen umschauen.